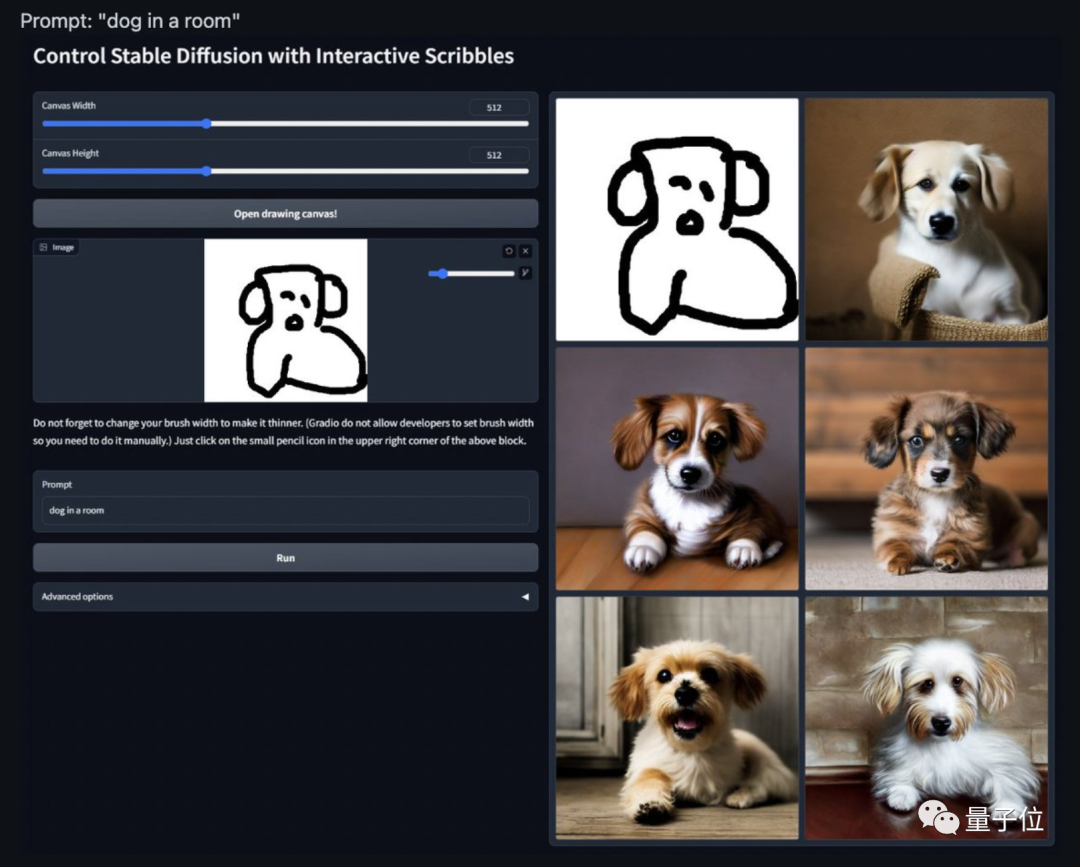

给画画AI加个buff,画起图像就像开了挂。

动漫

草图

手部细节

这个名叫ControlNet的新AI插件,可以说是给画画AI来了最后的“临门一脚”——

原本AI无法控制的手部细节、整体架构,有了它之后,加上Stable Diffusion这样的扩散模型,足以生成任何人们想要的图像。

发出不到两天,ControlNet就在GitHub上火了,目前已经狂揽4.6k星:

△

各种效果图更是在推特上爆火,试玩过的网友直呼:

游戏结束!

所以,这个ControlNet究竟给扩散模型加了什么buff?

给AI画画模型加buff

扩散模型

这里可以是各种类型的输入,作者给出来的有8种,包括草图、边缘图像、语义分割图像、人体关键点特征、霍夫变换检测直线、深度图、人体骨骼等。

那么,让大模型学会“按输入条件生成图片”的原理是什么呢?

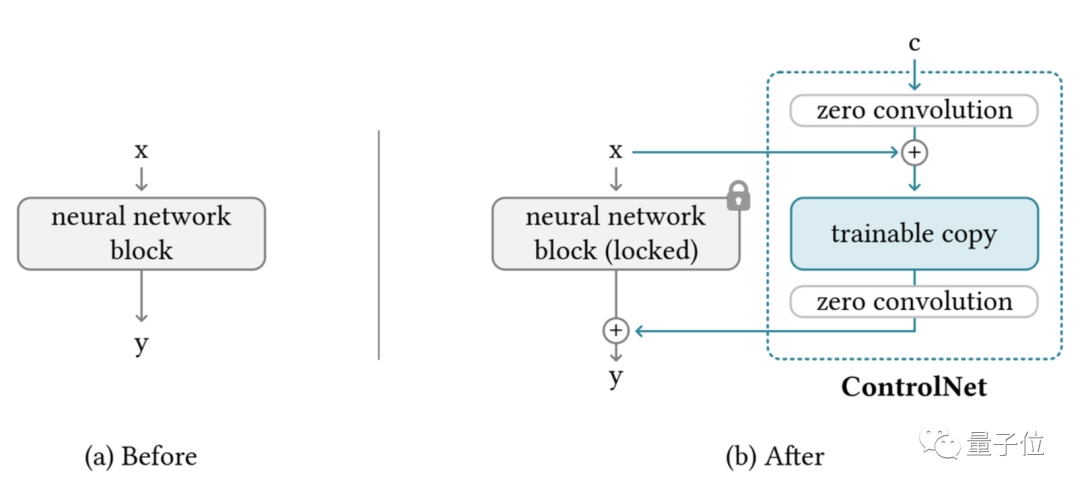

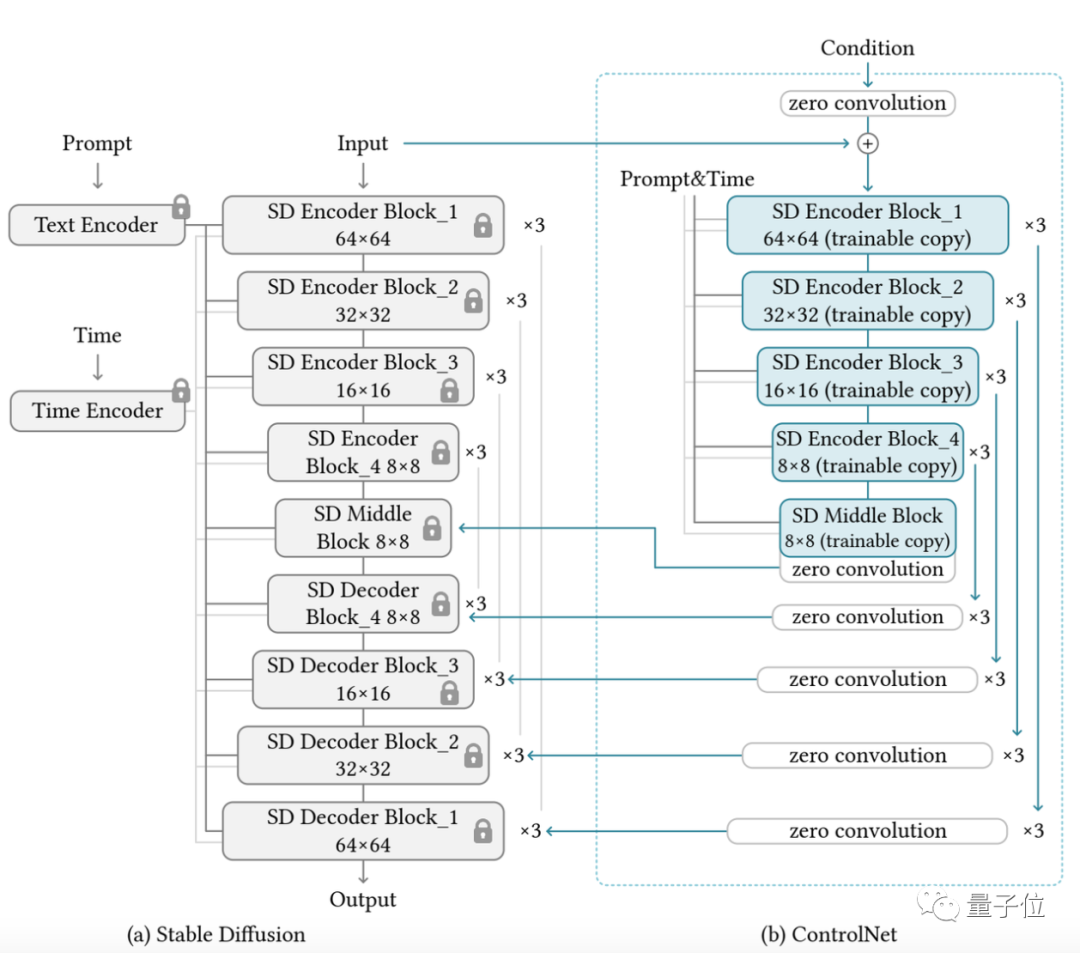

ControlNet整体思路和架构分工如下:

(trainable copy)

相比之下,原扩散模型经过几十亿张图片的预训练,因此参数是被“锁定”的。而这个“可训练副本”只需要在特定任务的小数据集上训练,就能学会条件控制。

(不超过5万张图片)

“锁定模型”和“可训练副本”通过一个1×1的卷积层连接,名叫“0卷积层”。

0卷积层的权重和偏置初始化为0,这样在训练时速度会非常快,接近微调扩散模型的速度,甚至在个人设备上训练也可以。

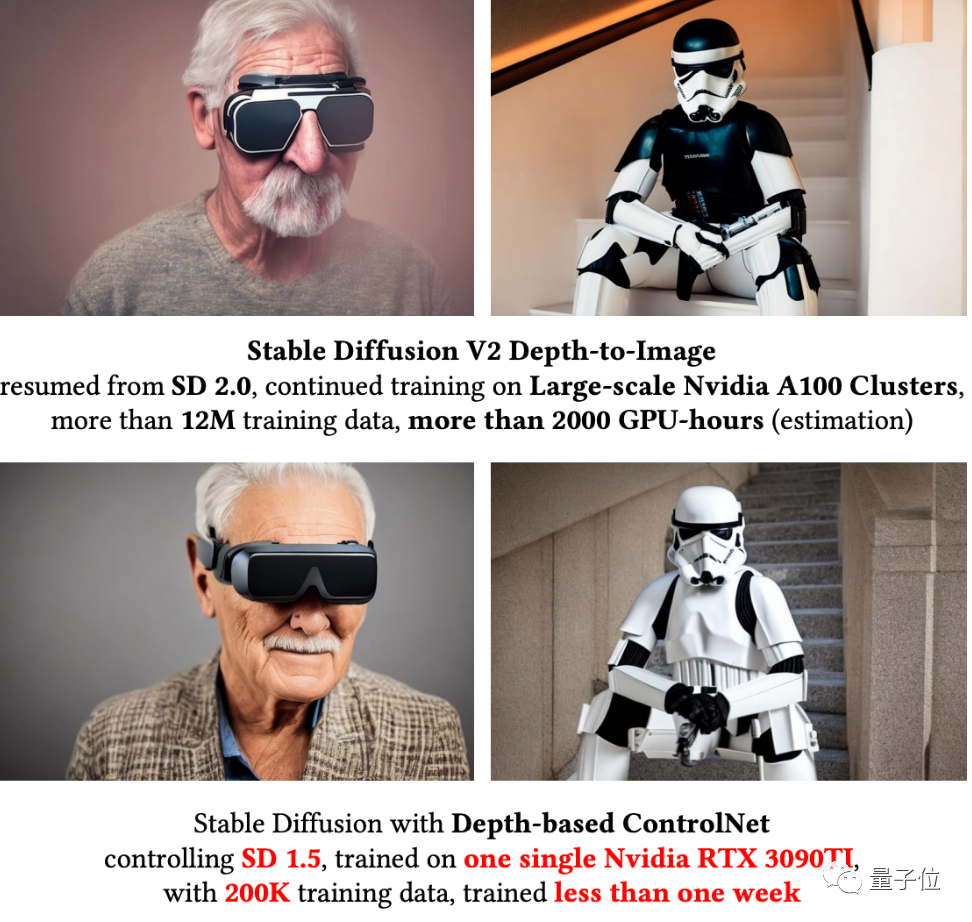

例如一块英伟达RTX 3090TI,用20万张图像数据训练的话只需要不到一个星期:

作者基于当前大火的Stable Diffusion进行了具体实现,主要架构如下:

针对不同的输入,作者也给出了对应不同的模型,生成效果也都不错。

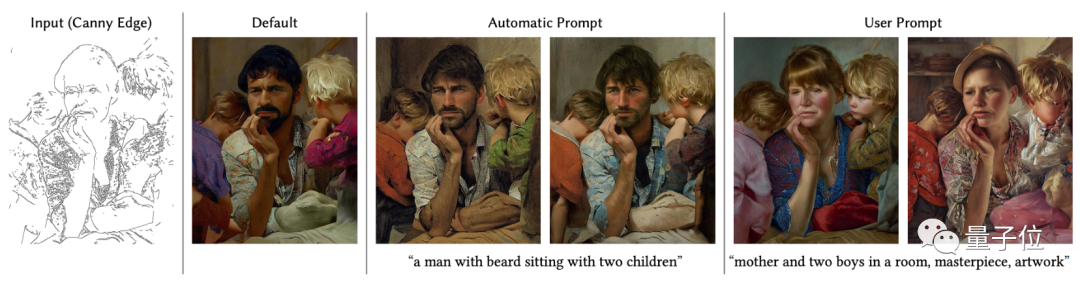

例如这是采用Canny边缘检测算法检测出的边缘,用于生成图像:

这是基于霍夫变换的直线检测算法生成的直线草图,用于生成各种风格的室内设计:

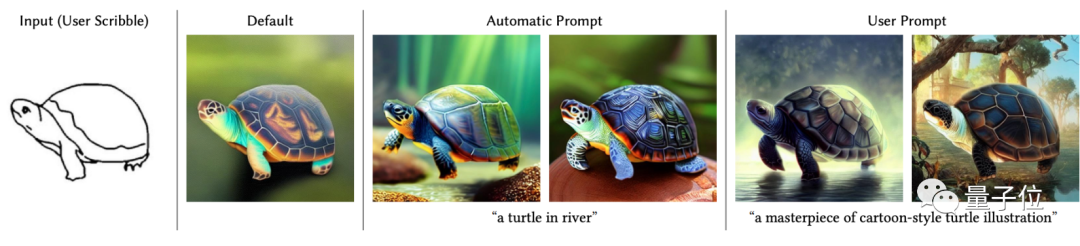

当然,自己作画也可以,例如这是基于用户草图生成的小龟:

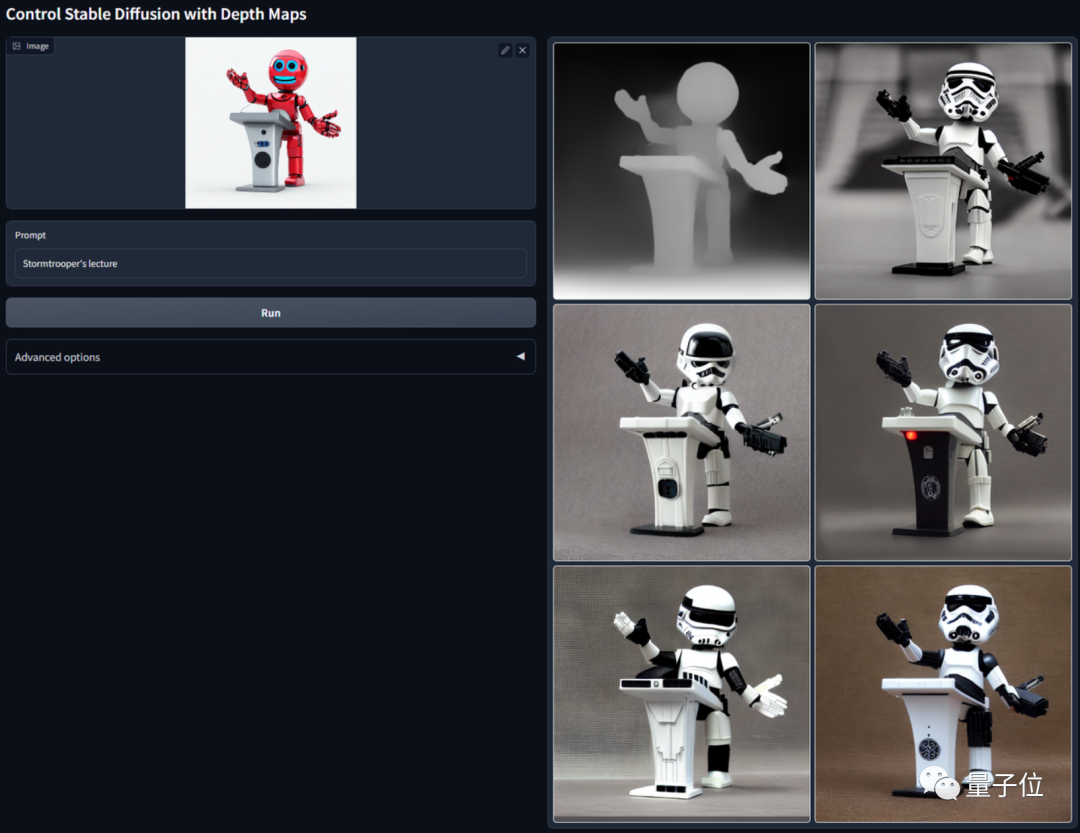

提取深度图,并让AI生成一幅相似的图像,直接举一反五:

语义分割下的游泳池图像,不仅水里有倒影细节,建筑也变化多样:

不过目前来看,最受欢迎的还是基于人体姿态估计算法,控制动漫人物的动作生成:

(手动狗头)

曾开发爆火AI上色插件

这个项目的作者Lvmin Zhang,2021年本科毕业于东吴大学,目前在斯坦福大学读博。

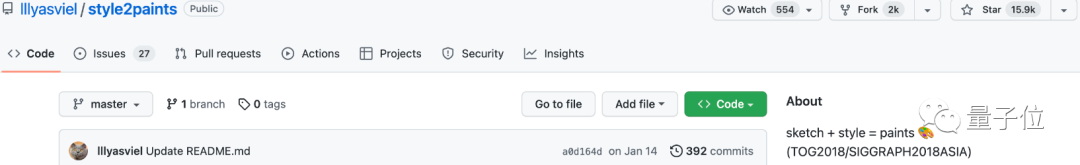

他最出名的项目之一,是2017年开发的AI上色插件style2paints,目前GitHub上已经有15.9k星。

style2paints也经过了好几次迭代,目前即将更新到第五版。

这是第四版的效果,只需要线稿,AI就能自动给你的图像完成上色:

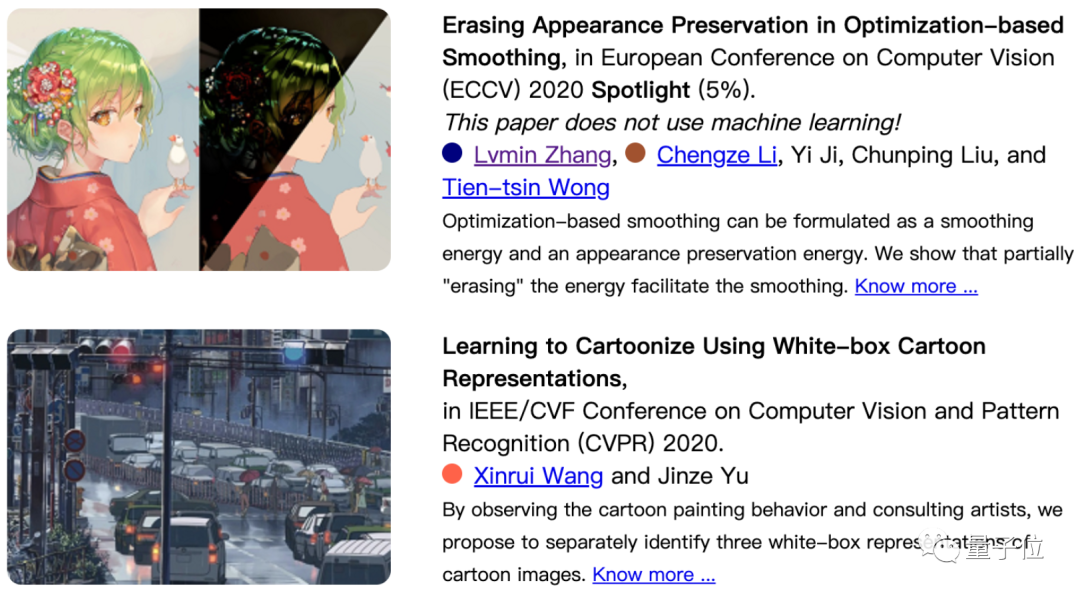

除了这个项目以外,他也是CV顶会的常客了。

One More Thing

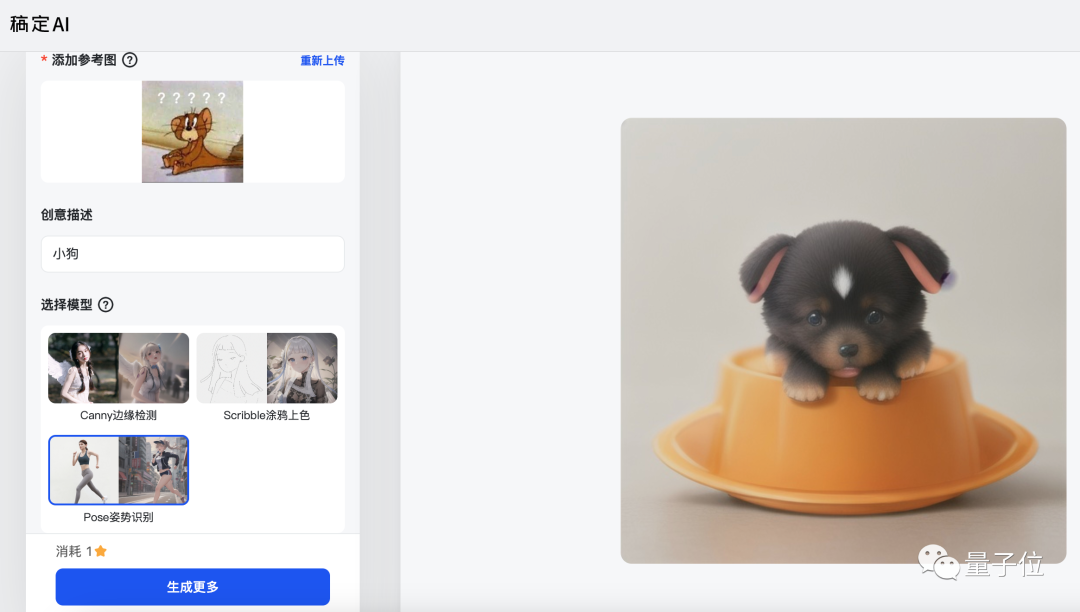

值得一提的是,现在已经有基于ControlNet的国内产品上线了。

这个产品名叫稿定AI,包含照片转插画、插画线稿上色、插画优化翻新等功能,正是基于ControlNet打造。

作画效果大概是酱婶的:

感兴趣的小伙伴们可以去试玩一波了~

项目地址:

https://github.com/lllyasviel/ControlNet

参考链接:

[1]https://lllyasviel.github.io/Style2PaintsResearch/

完

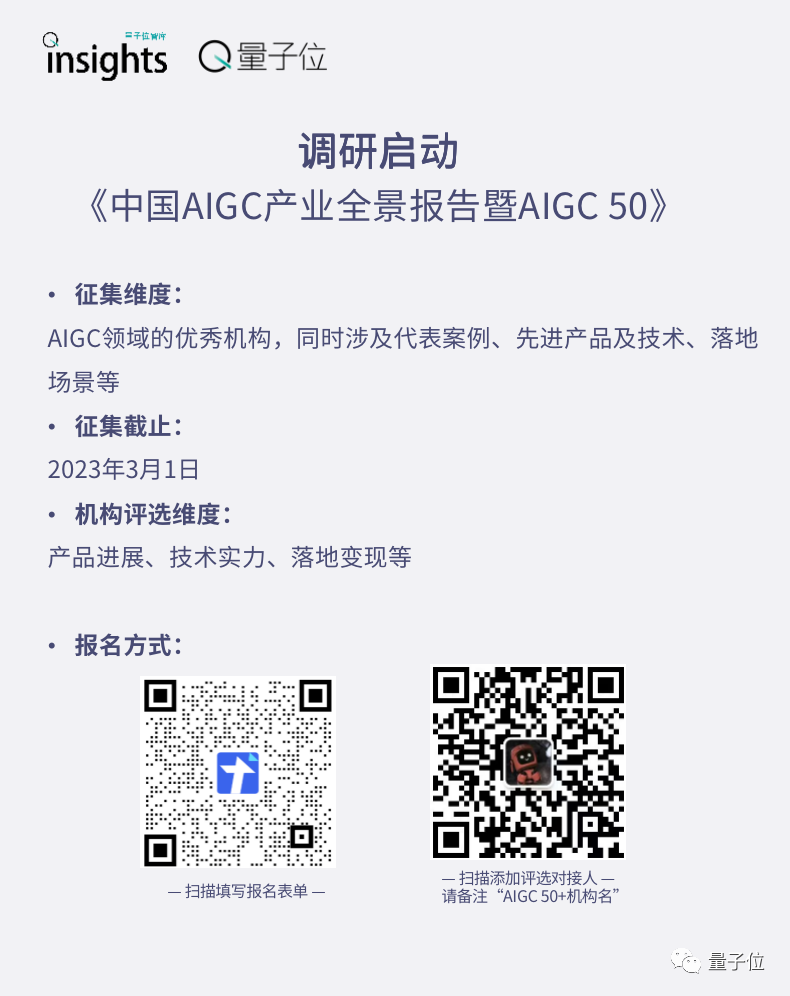

《中国AIGC产业全景报告暨AIGC 50》调研启动

谁会是中国的“ChatGPT”?最有竞争力和潜力的AIGC力量位于何方?

量子位《中国AIGC产业全景报暨AIGC 50》

👇

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

新智元报道 编辑:编辑部 【新智元导读】 一桩14年的悬案,至今仍然疑云重重。 故事的主人公Marc Tessier-Lavigne,如今斯坦福大学的校长,被自家日报「The Stanford Daily」强烈指控学术造假。 而校长在17号给所有斯坦福师生怒发邮件,急证自己的清白。 2009年,时任生物技术公司Genentech高管的Marc Tessier-Lavigne与其他人合著了一篇论文,发表在Nature上。 论文地址:https://pubmed.ncbi.nlm.nih.gov/19225519/ 这篇论文声称,发现了阿尔茨海默病患者脑部退化的潜在原因。 Genentech在致股东的年度信中写道:「由于这项研究,我们正在努力开发抗体和小分子,它们可能会从一个新的切入点攻击阿尔茨海默病,帮助目前数百万患有这种毁灭性疾病的患者。」 但随后,公司的四名科学家发现了不对劲:在多次尝试后,这项研究的结果始终无法复现。 随后,在2011年,这篇论文成为Genentech研究审查委员会内部审查的对象,由两位资深科学家和两位兼任高管的科学家负责。 他们的结论是:

朱俊彦 事情是这样的: 2D草图一键变成3D模型 配文全是“沃日”、“???”…… 一键变成逼真3D模型 还支持实时编辑,不满意的地方擦掉重画,立马生成一个新的: 要知道之前的“图转图”模型,基本都是停留在2D层面,这回直接变3D真是一个突破。 也确实是生产力利器。 但没想到,是设计圈先感到了危机。有圈内博主就觉得又要被AI抢饭碗了,随后也有很多人跟转了这一条。 所以论文成果到底说了啥?一起来看。 可从任意角度实时编辑 现在有很多图-图的转换模型,但基本上都是2D-2D。 这是因为从2D到3D,在训练和测试过程中都有很大挑战。 训练方面,想要把2D输入图像和3D输出图像配对,需要庞大数据集,成本会很高。 测试方面,为了得到不同角度的3D模型,需要输入图像的多个视角,但是二者之间可能存在不一致的情况,导致生成效果不好。 3D神经场景表示 每个3D点 任何视角 为了实现跨视图编辑,需要将额外的语音信息编码为3D的,然后通过图像重建和对抗损失(adversarial losses)的2D监督,